使用 Hugging Face 和其他开源存储库中的模型进行内部 AI 开发的公司需要关注供应链安全和检查漏洞。

攻击者正在寻找越来越多的方法将恶意项目发布到 Hugging Face 和其他开源人工智能 (AI) 模型的存储库,同时逃避网站的安全检查。不断升级的问题凸显了追求内部 AI 项目的公司需要建立强大的机制来检测其供应链中的安全漏洞和恶意代码。

例如,根据软件供应链安全公司 ReversingLabs 2 月 3 日发布的分析,Hugging Face 的自动检查最近未能检测到存储库上托管的两个 AI 模型中的恶意代码。威胁行为者使用一种常见的向量——使用 Pickle 格式的数据文件——和一种被称为“NullifAI”的新技术来逃避检测。

ReversingLabs 的首席软件架构师 Tomislav Pericin 说,虽然这些攻击似乎是概念验证,但它们成功使用“无问题”标签托管表明,公司不应依赖 Hugging Face 和其他存储库的安全检查来保证自身的安全。

“你有这个公共存储库,任何开发人员或机器学习专家都可以在其中托管他们自己的东西,显然恶意行为者会滥用它,”他说。“根据生态系统的不同,向量会略有不同,但想法是一样的:有人将托管一个事物的恶意版本,并希望你无意中安装它。”

公司正在迅速采用 AI,大多数公司还使用存储库中的开源 AI 模型(例如 Hugging Face、TensorFlow Hub 和 PyTorch Hub)建立内部项目。根据 IBM 赞助的 Morning Consult 对 2,400 名 IT 决策者的调查,总体而言,61% 的公司正在使用开源生态系统中的模型来创建自己的 AI 工具。

然而,许多组件可能包含可执行代码,从而导致各种安全风险,例如代码执行、后门、提示注入和对齐问题——后者是 AI 模型与开发人员和用户的意图的匹配程度。

在不安全的 Pickle 中

一个重要的问题是,一种常用的数据格式(称为 Pickle 文件)不安全,可用于执行任意代码。尽管安全研究人员发出了口头警告,但许多数据科学家仍在使用 Pickle 格式,HiddenLayer 是一家专注于 AI 的检测和响应公司,其研究副总裁 Tom Bonner 说。

“我真的希望我们能对此发出足够的声音,以至于 Pickle 现在已经过去了,但事实并非如此,”他说。“我见过组织通过机器学习模型遭到入侵 — 目前有多个 [组织]。所以,是的,虽然这不是勒索软件或网络钓鱼活动等日常事件,但它确实会发生。

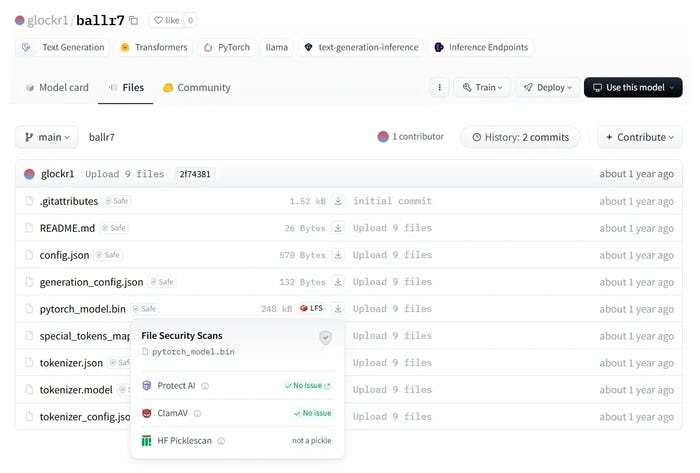

虽然 Hugging Face 对 Pickle 文件进行了显式检查,但 ReversingLabs 发现的恶意代码通过对数据使用不同的文件压缩来规避这些检查。应用程序安全公司 Checkmarx 的其他研究发现了多种绕过扫描程序的方法,例如 Hugging Face 使用的 PickleScan,以检测危险的 Pickle 文件。

尽管具有恶意功能,但该模型还是通过了 Hugging Face 的安全检查。来源:ReversingLabs

“PickleScan 使用了一个阻止列表,该列表使用两个内置的 Python 依赖项都成功绕过了该列表,”Checkmarx 应用程序安全研究总监 Dor Tumarkin 在分析中表示。“它显然很容易受到攻击,但通过使用 Pandas 等第三方依赖项来绕过它,即使它要考虑 Python 中嵌入的所有情况,它仍然容易受到其范围内非常流行的导入的攻击。”

数据科学和 AI 团队应该转向 Safetensors,而不是 Pickle 文件,Safetensors 是由 Hugging Face、EleutherAI 和 Stability AI 管理的新数据格式库,该库已经过安全审计。Safetensors 格式被认为比 Pickle 格式安全得多。

根深蒂固的 AI 漏洞

然而,可执行数据文件并不是唯一的威胁。许可是另一个问题:虽然预训练的 AI 模型通常被称为“开源 AI”,但它们通常不提供复制 AI 模型所需的所有信息,例如代码和训练数据。相反,它们提供训练生成的权重,并且由并不总是开源兼容的许可证所涵盖。

Endor Labs 的高级产品经理 Andrew Stiefel 说,从此类模型创建商业产品或服务可能会导致违反许可证。

“模型的许可证非常复杂,”他说。“你有实际的模型二进制文件本身、权重、训练数据,所有这些都可能有不同的许可证,你需要了解这对你的业务意味着什么。”

模型对齐 — 其输出与开发人员和用户的价值观的一致性程度 — 是最终的通配符。例如,研究人员发现,DeepSeek 允许用户创建恶意软件和病毒。其他模型——例如 OpenAI 的 o3-mini 模型,它拥有更严格的对齐方式——已经被研究人员越狱。

这些问题是 AI 系统独有的,如何测试这些弱点的界限仍然是研究人员的沃土,ReversingLabs 的 Pericin 说。

“已经有关于什么样的提示会触发模型以不可预测的方式行为、泄露机密信息或教授可能有害的事情的研究,”他说。“老实说,这是机器学习模型安全的另一门学科,人们今天最担心的是。”

公司应确保了解涵盖他们正在使用的 AI 模型的任何许可证。此外,他们应该注意软件安全的常见信号,包括模型的来源、围绕模型的开发活动、它的受欢迎程度以及作和安全风险,Endor 的 Stiefel 说。

“你需要像管理任何其他开源依赖项一样管理 AI 模型,”Stiefel 说。“它们是由组织外部的人构建的,而你正在引入他们,因此这意味着你需要采取相同的整体方法来看待风险。”

信息来源:https://www.darkreading.com/cyber-risk/open-source-ai-models-pose-risks-of-malicious-code-vulnerabilities

AI API 安全 DMARC 云安全 五角大楼 人工智能 人类心理学 关税 加密货币 勒索软件 品牌冒充 国家安全 威胁情报 应用程序安全 恶意软件 数字货币 时事政治 时政 时政新闻 暗网 木马病毒 欺诈管理和网络犯罪 民族国家攻击 漏洞和威胁 特朗普政府 特朗普的 2026 财年预算 社会工程学 社会工程学、网络战 移动安全 端点安全 网络危险 网络安全 网络安全运营 网络攻击和数据泄露 网络犯罪 网络罪犯 网络钓鱼 网络间谍 网络风险 美国贸易代表办公室 联邦贸易委员会 脆弱性 远程员工 金融与银行 间谍软件